La démocratisation de l’IA et en particulier des LLM, c’est à dire les outils de type ChatGPT, apportent leur lot de questionnement en terme d’impact notamment cybersécurité des IA.

Comment prendre en compte ces nouveaux outils dans une organisation ?

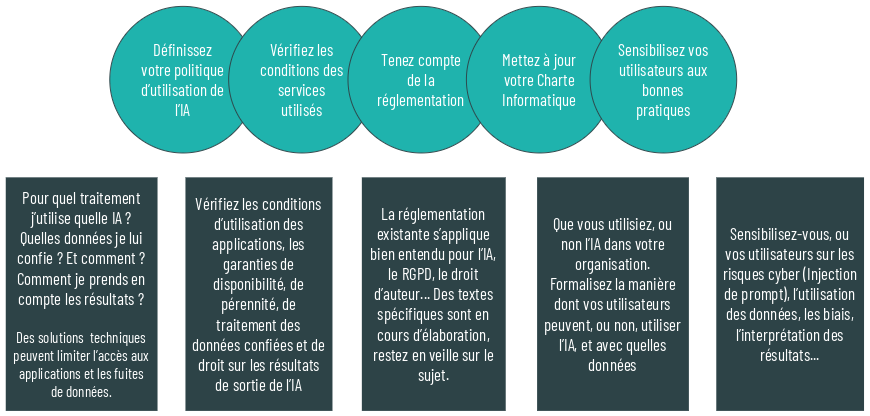

5 étapes essentielles pour prendre en compte ce changement.

Définir sa politique

Avant toute chose, que vous décidiez d’utiliser ou non des outils d’intelligence artificielle dans votre organisation, vous devez les prendre en compte dans votre politique.

En effet, vos collaborateurs sont certainement tentés de les utiliser, alors vous devez leur communiquer les pratiques à adopter, ou non, les données communicables, ou non, à des outils d’IA.

Les questions que vous pouvez vous poser pour définir votre politique :

- Pour quel traitement j’utilise quelle IA ?

- Quelles données je lui confie ? Et comment ?

- Comment je prends en compte les résultats ?

- …

Des solutions techniques existent pour se protéger notamment de « l’exfiltration » de données, ou de l’utilisation d’applications en ligne en particulier.

Par exemple, sur un firewall, il est possible de mettre en place du filtrage d’URL, du filtrage d’application, et également des outils de DLP : Data Loss Prevention. Ces derniers vont analyser les données qui sortent de votre réseau pour éventuellement les bloquer si elles sont reconnues comme des données personnelles, des numéros de carte bleu, RIB etc etc…

Vérifier les conditions des services utilisés

Vérifiez les conditions d’utilisation des applications, les garanties de disponibilité, de pérennité, de traitement des données confiées et de droit sur les résultats de sortie de l’IA.

En effet, si vous décidez d’automatiser tout ou partie d’un processus avec un outil d’Intelligence Artificielle en Saas, vous devez vous poser les même questions que pour tout autre produit numérique Saas.

- Qu’advient-il des données échangées avec l’outil ?

- Comment sont-elles traitées, stockées ?

- Que se passe-t-il si les conditions d’accès ou la disponibilité change ?

- …

Mais en plus de cela, des questions sont à se poser notamment sur les résultats notamment :

- Que ce soit du texte, de la vidéo, des images, du son : quel droit d’utilisation avez-vous sur ces résultats ?

- Quelle est leur fiabilité ? Le résultat est-il explicable ? (doit-il l’être ?)

- …

Tenez compte de la réglementation

Bien entendu, la législation existante s’applique pour l’Intelligence Artificielle comme pour tous les autres produits numériques.

Nous pouvons citer bien entendu le RGPD mais également le droit d’auteur.

Des textes spécifiques sont en cours d’approbation, notamment le règlement IA ACT. Ce dernier prévoit des exigence vis-à-vis principalement des fournisseurs de solutions d’Intelligence Artificielle, en fonction de la criticité des données exploitées.

Mettez à jour votre charte Informatique

Encore une fois, que vous utilisiez ou non l’IA, il est une bonne pratique de communiquer aux utilisateurs ce qu’ils peuvent, ou ne peuvent pas, faire avec les outils d’IA.

Formalisez dans la charte les outils autorisés, les données autorisées, la manière de traitement des résultats. Définissez et communiquez les conditions d’utilisation des IA que vous souhaitez voir appliquer.

Sensibilisez vos utilisateurs

Pour vous assurer que la charte informatique soit connue et comprise, sensibilisez vos utilisateurs aux usages autorisés de l’Intelligence Artificielle sur votre réseau et avec vos données.

Vous devez également les sensibiliser ou les former à l’interprétation des résultats, et dans le cadre d’un projet de mise en place d’une IA, vous devrez également les former afin de tirer le meilleur profit des outils mis en place.

Quelques vidéos sur la sécurité des IA

Micode (Chaine YT Underscore_) – Cyberattaques via ChatGPT

10 minutes :https://www.youtube.com/watch?v=ghVWFZ5esnU

Mikko Hypponen – Artificial Evil

32 minutes : https://www.youtube.com/watch?v=2i1QqCZKtqA

RISKINTEL MEDIA – Comment l’IA va bouleverser la cybersécurité et notre manière de travailler

1h10 : https://www.youtube.com/watch?v=rVESWOgK8UA

Sources et références cybersécurité des IA

- NIST – AI Risk Management Framework – https://airc.nist.gov/AI_RMF_Knowledge_Base/

- NIST – Adversarial Machine Learning – https://csrc.nist.gov/pubs/ai/100/2/e2023/final

- OWASP – AI Security and Privacy Guide – https://owasp.org/www-project-ai-security-and-privacy-guide/

- OWASP – Top 10 Machine Learning Security Risks (Draft) – https://owasp.org/www-project-machine-learning-security-top-10/

- OWASP – OWASP Top 10 for Large Language Model Applications – https://owasp.org/www-project-top-10-for-large-language-model-applications/

- OWASP – LLM AI Security & Governance Checklist (Brouillon) – https://owasp.org/www-project-top-10-for-large-language-model-applications/llm-top-10-governance-doc/LLM_AI_Security_and_Governance_Checklist.pdf

- ISO 42001 – System de Management Intelligence Artificielle – https://www.iso.org/fr/standard/81230.html – ISO/IEC 27090 (AI security) and 27091 (AI privacy)

- MITRE – MITRE ATLAS – https://atlas.mitre.org/

- IEEE – Artificial Intelligence and Machine Learning Applied to Cybersecurity (2017) – https://www.ieee.org/content/dam/ieee-org/ieee/web/org/about/industry/ieee_confluence_report.pdf

- IEEE – An Overview of Artificial Intelligence Ethics – https://ieeexplore.ieee.org/document/9844014

- ENISA – Multilayer Framework for Good Cybersecurity Pratices for AI – https://www.enisa.europa.eu/publications/multilayer-framework-for-good-cybersecurity-practices-for-ai

- ENISA – Artificial Intelligence and Cybersecurity Research – https://www.enisa.europa.eu/publications/artificial-intelligence-and-cybersecurity-research/

- LINC (CNIL) – Sécurité des systèmes d’IA – https://linc.cnil.fr/sites/linc/files/atoms/files/linc_cnil_dossier-securite-systemes-ia.pdf

- NCSN – Guidelines for secure AI system development – https://www.ncsc.gov.uk/collection/guidelines-secure-ai-system-development

- CNIL – Guide d’auto-évaluation pour les systèmes d’intelligence artificielle (IA) – https://www.cnil.fr/fr/intelligence-artificielle/guide

- CNIL – Conformité des systèmes d’IA : https://www.cnil.fr/fr/intelligence-artificielle/guide/conformite-des-systemes-dia-les-autres-guides-outils-et-bonnes-pratiques

- EU – AI Act – https://artificialintelligenceact.eu/fr/

- France Digitale – Article AI Act – https://media.francedigitale.org/app/uploads/prod/2024/02/01163100/Guide-Conformite-AI-Act-Fev-2024-1.pdf

- J&A – Article Droit d’Auteur – https://www.joffeassocies.com/droit-dauteur-quel-droit-sur-et-contre-les-creations-des-ia/